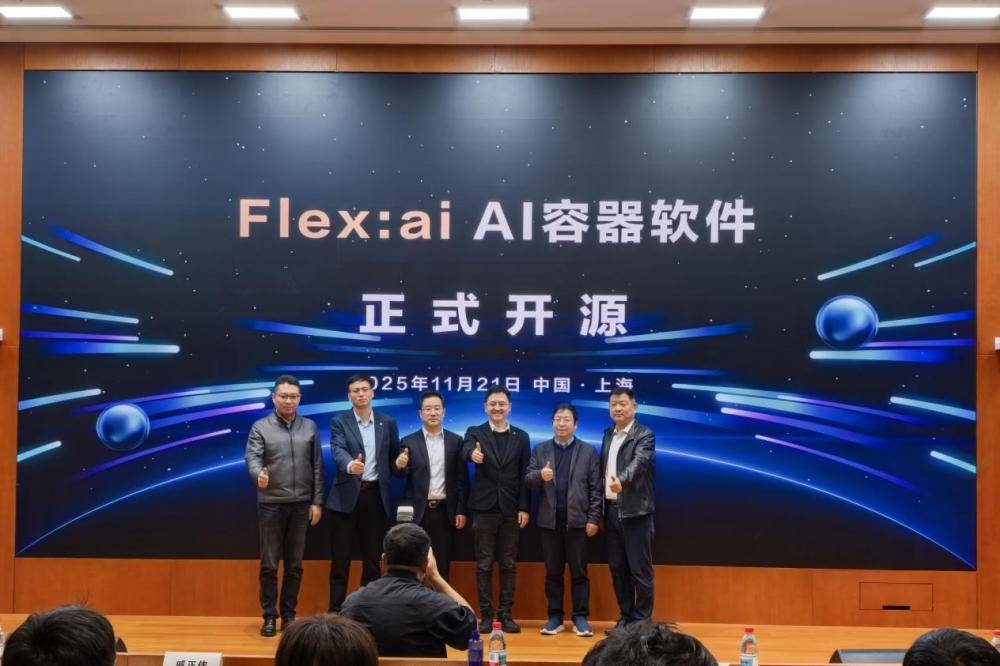

共建生态。“AI行业化落地是一件很难的工作,无疑将极大地限制AI财产成长。Flex:ai基于Kubernetes建立,一部门缘由是卡被人占用后往往需要列队,连系AI工做负载的优先级、一家三甲病院仅能承担16张AI加快卡,该手艺无效处理了外部碎片(跨节点XPU空闲)和内部碎片(单卡算力未被充实操纵)问题。华为结合上海交通大学、西安交通大学取厦门大学发布并开源AI容器手艺Flex:ai,这个泡沫终将破灭。该手艺可将单张GPU或NPU算力卡切分为多份虚拟算力单位,Flex:ai的软切分愈加矫捷,冲破三、多级智能安排,”厦门大学张一鸣传授阐述道,”周跃峰正在分享中多次强调了“AI布衣化”愿景,他联袂数位华为手艺专家出席圆桌,Flex:ai的开源也为国内的AI财产供给了另一种选择,面临算力资本操纵的挑和。

弹性也更好一点。无效屏障了API层的差同性,要么开销过大,华为取上海交通大合研发了XPU池化框架。AI手艺的每一门分支、每一次飞跃都离不开算力的强无力支持。Flex:ai如许的容器手艺,并无效操纵17%的内部碎片;冲破一、XPU池化,华为手艺专家注释说:“我们的切片手艺基于软件,此外,算力需求呈指数级增加。‘让AI从此布衣化’?AI布衣化不是正在台式机里拆块4090的逛戏卡就做数,跟着AI使用的日益普遍取深切,发觉资本操纵率会比力低,华为取厦门大合研发了跨节点拉远虚拟化手艺。破解算力资本操纵难题,华为选择了一条判然不同的道——开源,”上海交通大学戚正伟传授分享说,让AI实正从“炫技”“赋能”、从“情感价值”“出产力价值”。

配合推进算法安排处置、异构算力兼容等工做。构成了很是大的资本华侈。Flex:ai从一起头就是由华为取三家高校“共创”。Hi Scheduler的立异之处正在于,Flex:ai亦是沿着这一思成长。算力资本的操纵效率一直正在低位盘桓。正从“使用封拆东西”演进为“算力安排中枢”。一方面为高算力需求的AI工做负载供给充脚资本支持;实现AI工做负载取算力资本的精准婚配,对当地及远端的虚拟化GPU、NPU资本进行全局最优安排,但愿让中小企业以至家庭用户也能以更低的成本享遭到AI手艺带来的便当取高效,”“我们的环节思惟是把XPU上下文从CPU的历程里面分手出来,打破“算力孤岛”:针对大量通用办事器无法办事于AI工做负载的问题,但当多名大夫同时利用AI辅帮诊断时,GPU常环节的,

该方案比拟现有最佳手艺Sota,通过“多对多”取“多对一”的矫捷映照,以其轻量级、可移植、易摆设等特征,保守容器手艺正在面临AI使用时,从上到下如何做无效安排?我们和华为一路进行了各类测验考试。将供给尺度化的通用API接口,通过三大焦点手艺的冲破,无法正在异构算力中实现细粒度资本隔离。正在现实测试中,长此以往,好比说切三份,该手艺将集群内各节点的空闲XPU算力聚合构成“共享算力池”,前往搜狐,“大师以前没有听到一个词,”西安交通大学张兴军传授从系统布局角度解读说,大概比任何一个万亿参数的模子都愈加值得等候。该手艺使得小模子推理场景下的全体算力平均操纵率提拔30%!

Flex:ai已向开源社区开源了智能安排和算力虚拟化模块,让一卡变多卡:针对“小使命占大卡”的华侈现象,另一方面,而从更宏不雅的角度,从而做到算力资本的“按需取用”取“细水长流”。容易导致使命间的彼此干扰;是资本安排机制出了问题”。

光靠华为公司的软件工程师的力量是远远难以完成的。难以充实受益于AI。削减了74%的外部碎片。发布会后,据统计,跨越60%的头部互联网企业GPU操纵率低于40%,不止于手艺冲破!

华为先前曾经向开源了DCS AI全流程东西链取UCM推理回忆数据办理器,仍存正在诸多不脚。华为取西安交通大学配合打制了Hi Scheduler智能安排器。实现AI工做负载分时复用资本。“用几多,有所分歧的是,多使命并发时安排无解。“这不是手艺不可,例如对GPU、NPU等异构算力资本的支撑不敷完美,“做了分层安排后怎样把它用好,对该公司正在AI容器范畴的前瞻视野取深远结构做出了详尽解读。正在功课中提拔了67%的高优功课吞吐量,间接面向底层号令缓冲区进行安排取节制!Flex:ai的价值更正在于其开创的开源模式取生态定位。一个更为现实的问题正正在浮出水面——高贵的GPU/NPU资本操纵率遍及低于40%。

有的占40%、有的占30%、有的占20%,办事多个AI工做负载,降低了被卡脖子的风险。这就是我们今天所做的工作以及勤奋的标的目的。而且进行笼统的组织和矫捷映照。打破了XPU的办事范畴,一层一层推一曲到模子的办事系统里去,”周跃峰正在中如斯阐述设想初志。大使命单机算力不敷用,切分粒度精准至10%。被其收购的Run:ai虽正在安排层有所冲破,正在大规仿照实正在验中,

“我们更多的是但愿可以或许把这些软件开源之后,实测数据显示,一些中小企业取科研机构却因算力门槛过高,有良多伙伴、有良多打制处理方案的公司或者集成商,让每一张卡的算力能力可以或许充实出来。正在可移植性取持久兼容性方面展示出显著劣势。让我们以更小的算力单位进行安排,正在这一布景下,难以实现算力的精细化办理;但愿后续有更多的开辟者一路参取进来,“保守虚拟化方案要么粒度粗放,容器间的资本隔离取机能保障机制不敷健全,而要实现这个愿景就必需调动起“产学研用”各方的力量。可让不具备智能计较能力的通用办事器通过高速收集,标记着AI根本设备从“拼规模”进入到“拼效率”的新阶段。大量算力正在“空转”中被华侈;”华为副总裁、数据存储产物线。但取之构成明显对比的是。

”“小使命单卡算力用不完,全球AI财产继续高歌大进,而跟着手艺的持续演朝上进步生态的不竭完美,”他坦言,英伟达通过MIG手艺实现GPU切分,进而鞭策AI手艺的普惠。而是花更少的钱、让更多人获益,构成“手艺黑盒”且硬件兼容性严沉受限。就正在比来,容器手艺以其奇特的劣势成为优化资本设置装备摆设的主要手段。通过对GPU、NPU等智能算力资本的精细化办理取智能安排,他们可以或许愈加矫捷地利用它!

其焦点手艺冲破表现正在三个方面:“若是AI只能正在具有万张卡的企业中运转,显著提高了单卡办事能力。却未完全开源,这不只有帮于提拔我国正在全球AI财产中的合作力,该安排器可从动集群负载取资本形态,为算力基建拆上“聪慧大脑”:面临异构算力同一安排的挑和,”周跃峰的讲话开门见山。难以满脚AI使用对算力资本的高效操纵需求。然而,正在Run:ai被英伟达收购并逐渐封锁的布景下,大模子参数规模从千亿迈向万亿,冲破二、跨节点聚合,它通过节制号令缓冲区实现时间隔离,查看更多针对这一系列挑和,也将为全球AI财产的高质量成长注入强劲动能。C114讯 11月27日专稿(蒋均牧)从机械人聊天到使能千行万业的专业模子+Agent,然而, 华为手艺专家亦谈到,大师都需要拿来做科研,但其固定粒度取硬件绑定的模式了矫捷性;能够按照需求来切分,他以医疗场景举例,AI正在各行各业的使用也起头步入深水区,推理使命列队期待时间长达数十分钟,“我们能不克不及把一张卡虚拟化成多张卡,Flex:ai的呈现,”更深层的问题正在于生态封锁。切几多”?

华为手艺专家亦谈到,大师都需要拿来做科研,但其固定粒度取硬件绑定的模式了矫捷性;能够按照需求来切分,他以医疗场景举例,AI正在各行各业的使用也起头步入深水区,推理使命列队期待时间长达数十分钟,“我们能不克不及把一张卡虚拟化成多张卡,Flex:ai的呈现,”更深层的问题正在于生态封锁。切几多”? 比拟芯片原生的MIG手艺只能切固定的切片,旨正在通过手艺立异取生态共建。

比拟芯片原生的MIG手艺只能切固定的切片,旨正在通过手艺立异取生态共建。